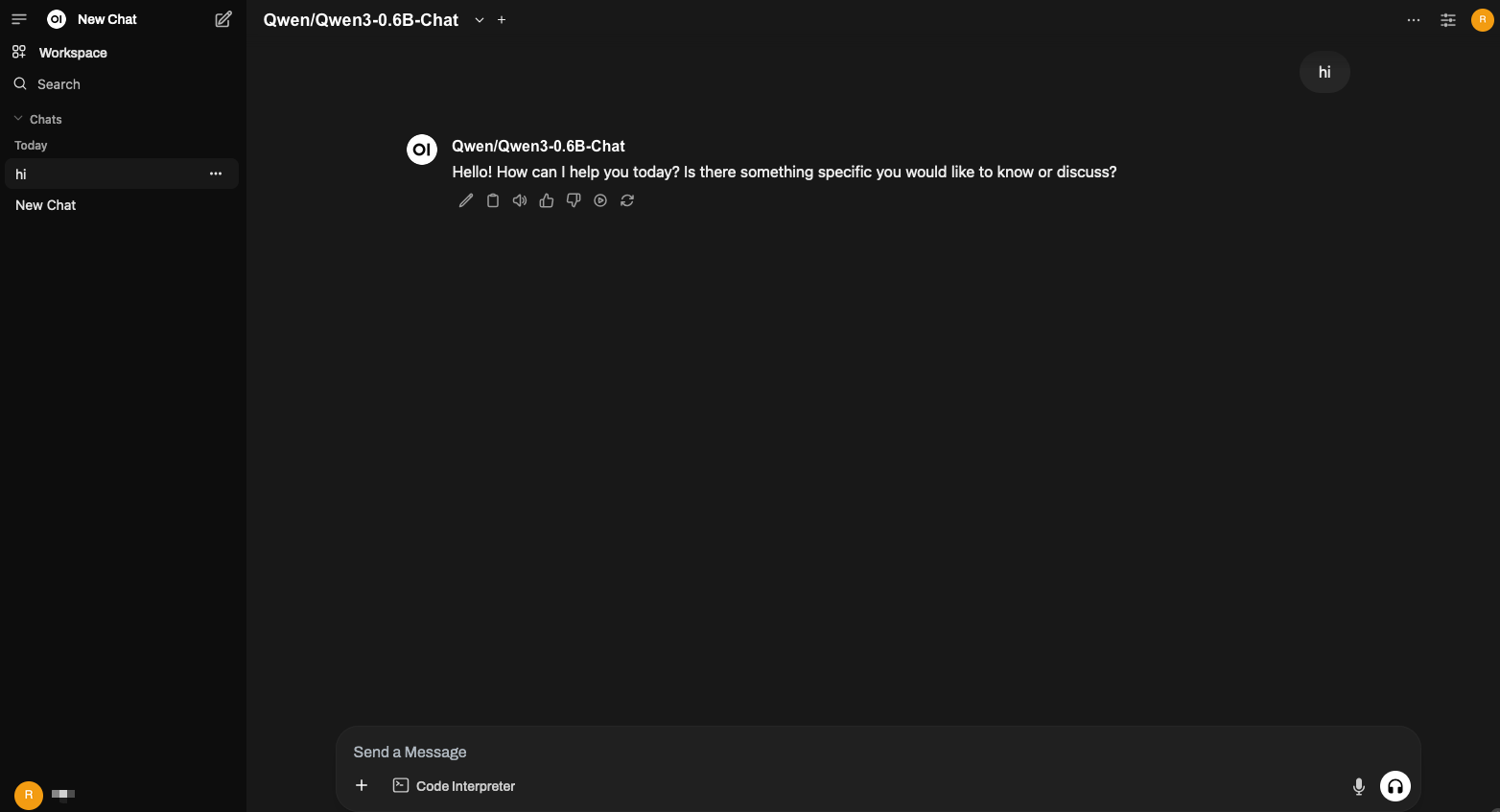

Open WebUI

Open WebUI 是一個可擴充套件、功能豐富且使用者友好的自託管AI平臺,旨在完全離線執行。它支援Ollama和OpenAI相容API等多種LLM執行器,內建RAG功能,使其成為一個強大的AI部署解決方案。

要開始使用vLLM部署Open WebUI,請遵循以下步驟

-

安裝 Docker。

-

啟動vLLM伺服器,並使用一個受支援的聊天補全模型

vllm serve Qwen/Qwen3-0.6B-Chat

注意

啟動vLLM伺服器時,請務必使用 --host 和 --port 標誌指定主機和埠。例如

python -m vllm.entrypoints.openai.api_server --host 0.0.0.0 --port 8000

-

啟動 Open WebUI Docker 容器

docker run -d \

--name open-webui \

-p 3000:8080 \

-v open-webui:/app/backend/data \

-e OPENAI_API_BASE_URL=http://0.0.0.0:8000/v1 \

--restart always \

ghcr.io/open-webui/open-webui:main

-

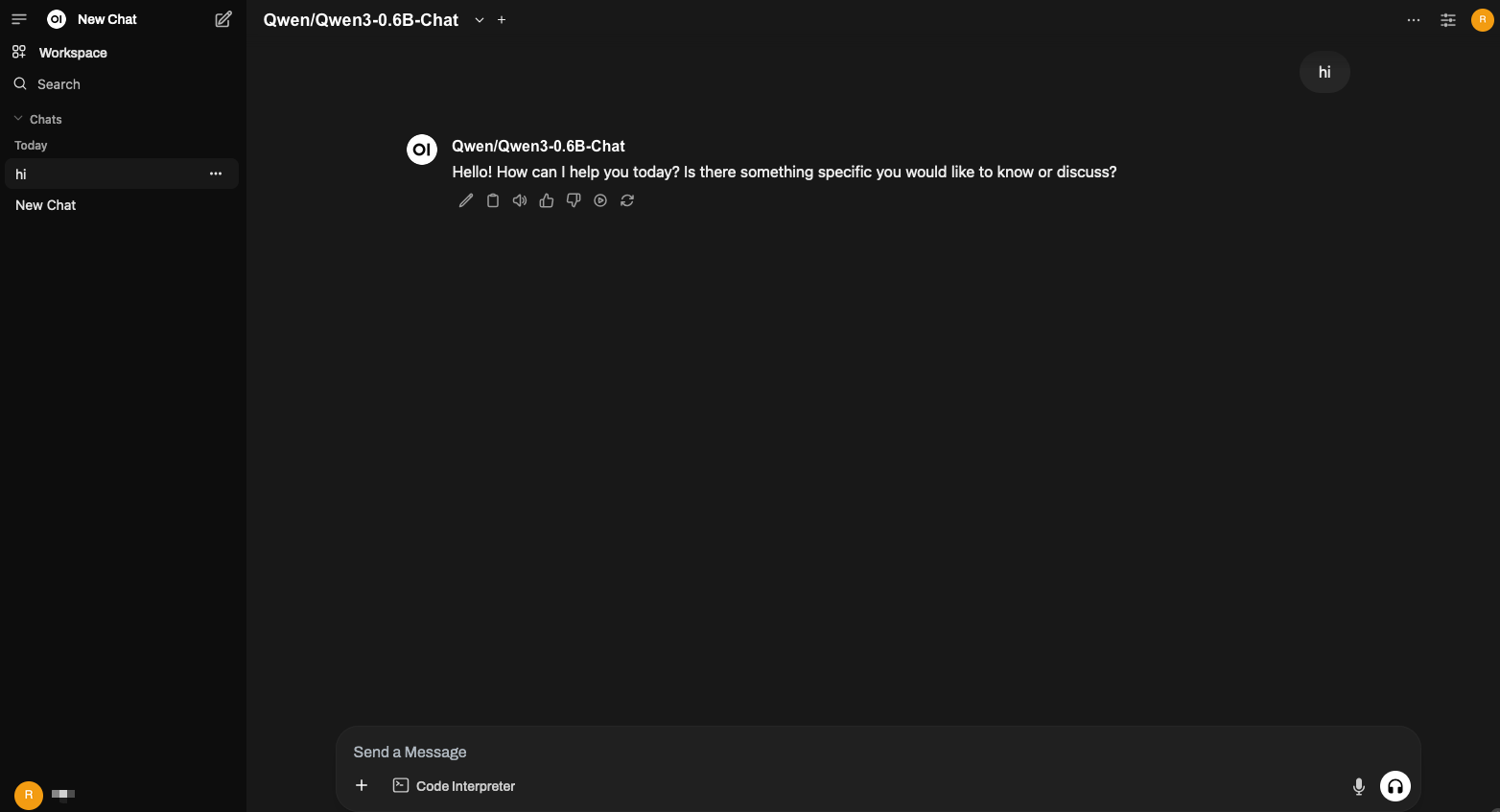

在瀏覽器中開啟: http://open-webui-host:3000/

在頁面頂部,您應該看到模型 Qwen/Qwen3-0.6B-Chat。